آخر الأخبار

كلاود فلير تُساعد المواقع الإلكترونية على مكافحة روبوتات الذكاء الاصطناعي

أعلنت شركة كلاود فلير Cloudflare، المزود الرائد لخدمات الحوسبة السحابية، عن إطلاق أداة جديدة مجانية تهدف إلى منع الروبوتات من استخلاص البيانات من مواقع الويب المستضافة عبر منصتها. تأتي هذه الأداة في وقت تتزايد فيه المخاوف بشأن استخدام البيانات غير المصرح به لتدريب نماذج الذكاء الاصطناعي، وهي مشكلة تزداد تعقيداً مع تطور هذه التقنيات.

تعتمد نماذج الذكاء الاصطناعي الحديثة على كميات هائلة من البيانات للتدريب، وغالباً ما يتم جمع هذه البيانات عبر روبوتات الزحف على الويب. تسمح بعض شركات الذكاء الاصطناعي، مثل جوجل وآبل وOpenAI، لأصحاب المواقع بحظر روبوتاتها من خلال تعديل ملف robots.txt، وهو ملف نصي يحدد الصفحات التي يمكن للروبوتات الوصول إليها على الموقع. لكن، كما أوضحت كلاود فلير في تدوينة تعلن فيها عن أداتها الجديدة، لا تلتزم جميع روبوتات استخلاص البيانات بهذه التعليمات.

صرحت كلاود فلير في تدوينتها: “لا يرغب العملاء في زيارة روبوتات الذكاء الاصطناعي لمواقعهم الإلكترونية، وخاصة تلك التي لا تلتزم بما هو موجود ضمن robots.txt. نخشى أن تتكيف بعض شركات الذكاء الاصطناعي التي تنوي التحايل على القواعد للوصول إلى المحتوى باستمرار للتهرب من اكتشاف الروبوتات.”

كيفية عمل الأداة

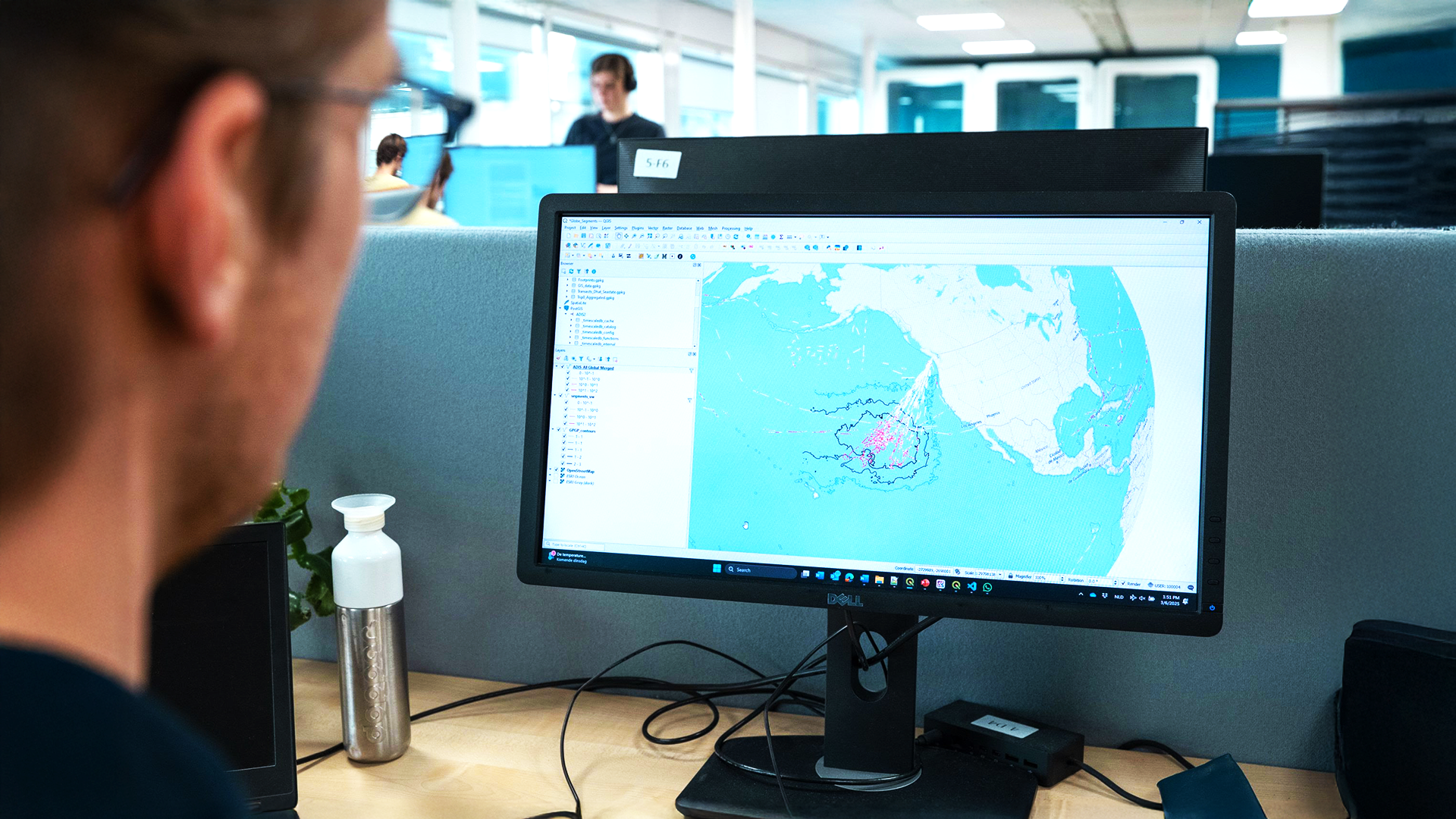

لمعالجة هذه المشكلة، قامت كلاود فلير بتحليل حركة مرور روبوتات الذكاء الاصطناعي لتطوير نماذج متقدمة للكشف التلقائي عن الروبوتات. تأخذ هذه النماذج في الاعتبار عدة عوامل، بما في ذلك محاولات الروبوتات لتجنب الكشف عن طريق محاكاة سلوك الأشخاص الذين يستخدمون متصفح الويب.

وأضافت كلاود فلير: “عندما تحاول الجهات الفاعلة الزحف إلى مواقع الويب على نطاق واسع، فإنها تستخدم عمومًا الأدوات والأطر التي يمكننا تحديدها. استنادًا إلى هذه الإشارات، فإن نماذجنا قادرة على تحديد حركة المرور من روبوتات الذكاء الاصطناعي المخادعة بصفتها روبوتات.”

أعدت كلاود فلير نظامًا يتيح للمضيفين الإبلاغ عن روبوتات الذكاء الاصطناعي المشتبه بها، وتقول إنها ستستمر في إدراج الروبوتات في القائمة السوداء يدويًا مع مرور الوقت. تأتي هذه الإجراءات في ظل تزايد الحاجة إلى حماية البيانات والمحتوى الرقمي من الاستخلاص غير المشروع، خاصةً بعد ازدهار الذكاء الاصطناعي وزيادة طلبه على بيانات التدريب.

تأثير الأداة على صناعة الذكاء الاصطناعي

برزت مشكلة روبوتات الذكاء الاصطناعي بعد أن أدى ازدهار الذكاء الاصطناعي إلى زيادة طلب بيانات تدريب النموذج. واختارت مواقع عديدة، تشعر بالقلق من تدريب نماذج الذكاء الاصطناعي على محتواها دون تنبيه أو تعويض، حظر روبوتات الذكاء الاصطناعي.

تتجاهل بعض شركات الذكاء الاصطناعي قواعد استبعاد الروبوتات للحصول على ميزة تنافسية في سباق الذكاء الاصطناعي. على سبيل المثال، اتُهم محرك بحث الذكاء الاصطناعي Perplexity سابقًا بانتحال هوية زوار شرعيين لاستخلاص محتوى من مواقع الويب. ويقال إن OpenAI وAnthropic تجاهلتا في بعض الأحيان قواعد ملف robots.txt.

التحديات المستقبلية

وفي رسالة إلى الناشرين في الشهر الماضي، قالت الشركة الناشئة في مجال ترخيص المحتوى TollBit إنها ترى أن عملاء الذكاء الاصطناعي يتجاهلون معيار ملف robots.txt. تستطيع أداة كلاود فلير أن تساعد إذا أثبتت دقتها في اكتشاف روبوتات الذكاء الاصطناعي، مع أنها لن تحل المشكلة المعقدة المتمثلة في مخاطرة الناشرين بالتضحية بحركة الإحالة من أدوات الذكاء الاصطناعي، مثل Google AI Overviews، التي تستبعد المواقع من التضمين إذا حظرت روبوتات ذكاء اصطناعي محددة.

بإطلاق هذه الأداة الجديدة، تأمل كلاود فلير في توفير مستوى أعلى من الحماية لأصحاب المواقع ضد الاستخلاص غير المصرح به للبيانات، مما يساهم في خلق بيئة رقمية أكثر أمانًا واستدامة للجميع.